[보안뉴스 원병철 기자] 구글이 2018년 발표한 BERT(Bidirectional Encoder Representations from Transformers)는 자연어 처리(NLP) 모델이다. BERT는 기존 모델들이 문맥을 한 방향으로만 파악했던 한계를 극복하고, 문장 전체의 문맥을 양방향으로 이해함으로써 문장의 모든 단어를 학습하고, 문장의 연결 관계를 학습하며 언어에 대한 깊은 이해를 습득한다. 특히 BERT는 사용자의 질문에 담긴 의도를 정확하게 파악해 관련성 높은 검색 결과를 제공해 검색엔진이나 질의응답 시스템 등에 널리 활용됐다.

[자료: gettyimagesbank]

특히 BERT와 같은 자연어 처리 모델로 악성 트래픽을 탐지하면, 패턴 인식 능력과 정교한 탐지로 인한 오탐이 감소해 탐지 정확도를 높일 수 있으며, 사전에 정의되지 않은 ‘제로데이(Zero-day) 공격’을 탐지하는 데도 유리해 많이 활용된다.

오는 8월 26일과 27일 양일간 서울 코엑스에서 개최되는 ‘ISEC 2025(제19회 국제 시큐리티 콘퍼런스)’에서 보안 담당자를 위한 실습 교육 ‘ISEC Training Course’에서는 이러한 자연어 처리 모델(BERT)을 활용한 악성 트래픽 자동 탐지 실습 교육을 진행한다. 실습은 개인 노트북에 JupyterLab 환경을 직접 설치하고 기본 사용법을 배우며, 이를 통해 실습 데이터를 로드하고 분석 코드를 작성하며, 탐지 모델을 실행하는 전 과정을 배울 수 있다.

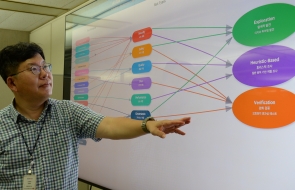

먼저 BERT 모델의 구조를 이해하고 배워, BERT 모델의 임베딩(Embedding)과 어텐션(Attention) 메커니즘을 이해한다. 또한, 이러한 구조인 학습 모델이 텍스트 데이터(페이로드)를 어떻게 해석하고 중요한 부분을 찾아내는지를 분석해 지식을 습득할 수 있다. 또한 사전학습(Pre-training)과 미세조정(Fine-tuning) 개념을 통해, 사전에 학습된 모델을 실제 환경에 맞게 조정하는 방법을 배운다.

실습에서는 BERT 기반 악성 페이로드 분류 모델을 만들고, 정상·악성 페이로드를 구분해 봅니다. 단순히 분류 모델을 생성하는 것 뿐만 아니라 결과를 직접 확인하고 분석을 통해 어떤 결과가 나타나는지 알 수 있다.

또한, XAI 모델을 통해 예측 결과를 막대그래프와 워드클라우드로 시각화해 모델이 어떤 단어를 중요하게 판단했는지 분석한다. 이러한 시각화는 보안 담당자가 모델의 탐지 근거를 이해하고 신뢰성을 높이는 데 이해하기 쉽게 보조역할을 하며, 실무에서 신속한 결정을 하는 데 도움을 줄 수 있다.

이후 다양한 탐지 시나리오를 실험해 ‘False Positive(정상인데 악성으로 탐지)’와 ‘False Negative(악성인데 탐지 실패)’ 사례를 직접 경험할 수 있다. 이를 통해 인공지능 기반 악성 탐지 시스템이 가진 한계를 이해하고, 실제 운영 환경에서 발생할 수 있는 문제에 대비할 수 있다.

마지막으로 실제 악성코드 유포 사례 분석을 통해 Emotet, Qakbot 등 최신 악성코드가 어떤 네트워크 프로토콜을 통해 어떤 형태의 페이로드로 전파되는지를 살펴보고, 이를 Wireshark 도구로 직접 실습을 통해 분석해 본다. 이러한 최신 사례 학습은 단순한 기술 연습을 넘어, 실제 보안 현장에서 즉시 대응할 수 있는 능력을 길러준다.

[원병철 기자(boanone@boannews.com)]

<저작권자: 보안뉴스(www.boannews.com) 무단전재-재배포금지>

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)