AI 활용 서비스를 악용한 사례로는 피싱 메일을 생성하고 배포하는 웜GPT(Worm GPT)가 있다. 사이버 범죄용 인공지능 챗봇 웜GPT가 해커들에 의해 악용돼 피싱 메일이 대량으로 생성되고 배포된다. 웜GPT는 비영리 오픈소스 그룹인 일루서AI(EleutherAI)의 ‘GPTJ’ 모델을 기반으로 멀웨어 관련 데이터셋을 학습해 다양한 기능을 보유하고 있다.

생성형 AI 기술의 대표적인 보안 위협으로는 크게 △잘못된 정보 △유사 AI 모델 서비스 빙자 △데이터 유출 △API 취약점 등으로 나눌 수 있다. 먼저 ‘잘못된 정보’는 AI 모델이 부정확한 정보를 제공해 사회적 혼란 증가와 고위험한 의사 결정을 유도해 오인을 유발하는 부적절한 결정을 초래한다.

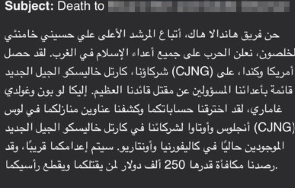

‘유사 AI 모델 서비스 빙자’는 악성 AI 모델을 활용한 사기 행위다. 피싱 이메일, 신원 도용, 사이버 보안 위협 코드 작성 등으로 사이버 공동체를 악용하며 사회공학적 영향을 끼치고 거짓된 정보를 전파할 수 있다.

‘데이터 유출’은 데이터 수집 및 AI 모델 자체에서 발생하는 정보 노출이다. 훈련 데이터 및 기밀 정보 노출과 대화 기록 유출로 인한 데이터 처리 우려와 함께 데이터베이스 침입 등 보안 측면에서의 중요한 문제가 발생할 수 있다.

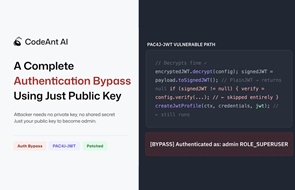

마지막으로 ‘API 취약점’은 인증 및 권한 부여 취약성 악용으로 인가되지 않은 액세스 및 권한 탈취 공격이 발생할 수 있다.

생성형 AI 보안 위협의 대응방안으로는 비공개 정보나 개인정보와 같이 민감한 정보의 입력을 금지하고, 설정에서 ‘채팅 이력 및 학습’ 기능을 끌 것, 생성물의 정확성·윤리성·적합성 등을 재평가, 가짜 뉴스 유포와 불법물 제작 및 해킹 등 범죄 목적으로의 악용은 금지하는 것 등이 있다. 의도적으로 거짓 정보를 입력하거나 학습을 유도하는 것은 비윤리적으로 허용하지 않으며, 연계 및 확장 프로그램을 사용할 때 보안 취약점을 점검해 안전성을 확인해야 한다. 로그인 계정에 대한 안전한 설정 강화 및 철저한 보안 관리, 다중 인증(Multi-Factor Authentication) 설정 등을 활용하는 것도 중요하다.

[제작=서울여자대학교 정보보호학과 제21대 학생회 플래그]

<저작권자: 보안뉴스(www.boannews.com) 무단전재-재배포금지>

.png)

.jpg)

.jpg)

.jpg)

_m.jpg)